Crawl4AI:AI 时代最火的开源网页爬虫,专为 LLM 量身打造!

嘿,AI 开发者们,你们还在为网页数据抓取烦恼吗?手动写 Selenium 脚本、处理 JS 动态加载、清理一堆垃圾内容……这些痛点,Crawl4AI 一键搞定!这个 GitHub 上星标超 50k 的开源项目,已经成为 2025 年最热门的网页爬取工具,尤其适合构建 RAG 系统、AI 代理和数据管道。别再用老古董了,来试试这个“LLM 友好型”爬虫吧!

工具简介

Crawl4AI 是一个开源的网页爬虫和刮取器,核心使命就是把乱七八糟的网页内容转换成干净、结构化的 Markdown,直接喂给大语言模型(LLM)吃。它支持动态内容渲染、媒体提取、结构化数据抽取,还能智能过滤噪音。

核心功能:

- 生成带引用和格式的干净 Markdown

- 支持 CSS/XPath 或 LLM 驱动的结构化提取

- 处理 JS 动态页面、懒加载、无限滚动

- 浏览器池管理、代理、隐身模式

- Docker 部署 + API 服务

适合谁? Python 开发者、AI 工程师、构建 RAG/代理的同学、需要自托管数据管道的企业。如果你正在用 LangChain、LlamaIndex 或自建 AI 应用,这家伙绝对是你的好帮手。

使用方法

上手超级简单,几分钟就能跑起来。

安装步骤(推荐 async 版本):

1. pip install -U crawl4ai

2. 运行 crawl4ai-setup(自动安装 Playwright 浏览器)

3. 检查:crawl4ai-doctor

如果想用 Docker:

docker pull unclecode/crawl4ai:latest

docker run -d -p 11235:11235 --shm-size=1g unclecode/crawl4ai:latest

然后访问 http://localhost:11235/playground 测试。

简单用法示例:

抓取一个新闻页面并输出 Markdown:

import asyncio

from crawl4ai import AsyncWebCrawler

async def main():

async with AsyncWebCrawler(verbose=True) as crawler:

result = await crawler.arun(url="https://www.swjsj.com")

print(result.markdown) # 直接得到干净 Markdown!

asyncio.run(main())

想结构化提取?用 LLM 或 CSS:

from crawl4ai import LLMExtractionStrategy

strategy = LLMExtractionStrategy(schema={"title": "str", "price": "float"})

result = await crawler.arun(url="https://www.swjsj.com", extraction_strategy=strategy)

print(result.extracted_content) # JSON 输出

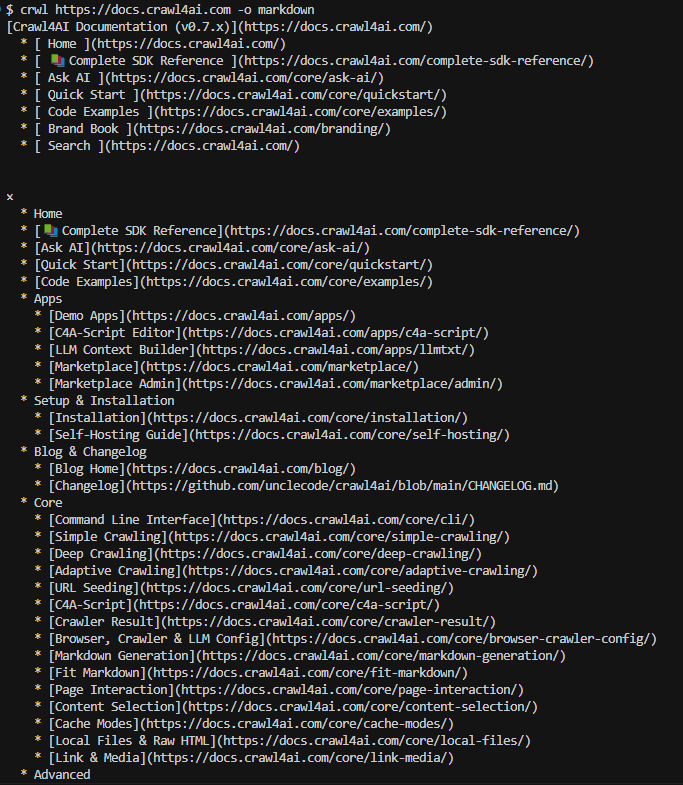

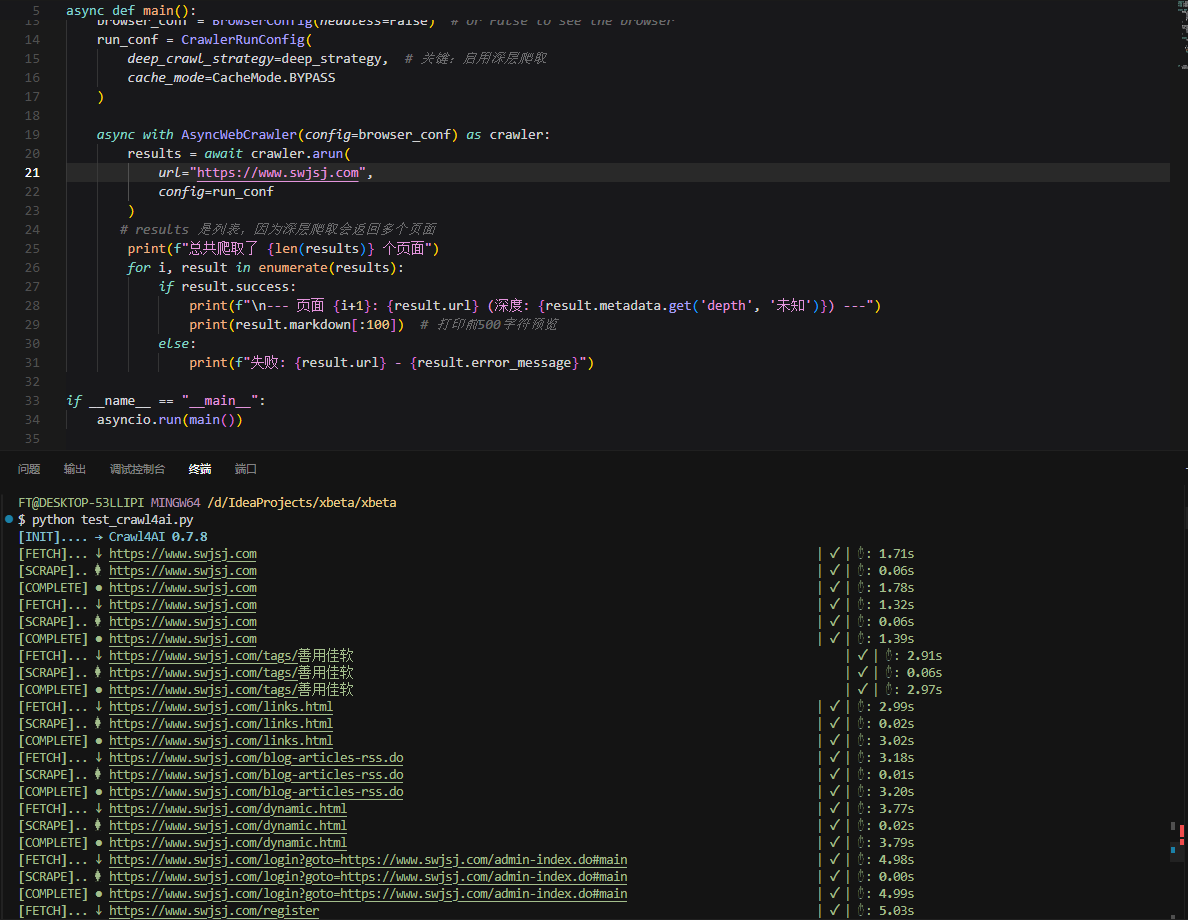

CLI 也支持:crwl https://docs.crawl4ai.com -o markdown

优势亮点

相比传统工具(如 BeautifulSoup、Selenium、Scrapy),Crawl4AI 的杀手锏在于:

- 完全开源免费:无 API Key、无订阅、自托管零成本

- AI 加持:输出专为 LLM 优化,带语义引用、智能分块、噪音过滤(BM25 算法)

- 异步高性能:浏览器池 + Playwright,批量爬取飞起

- 灵活控制:自定义钩子、会话持久化、代理/隐身模式、防反爬

- 生产就绪:Docker + FastAPI + 监控仪表盘,支持大规模部署

- 社区活跃:GitHub 最星标爬虫,文档齐全、更新频繁

一句话:它不只是爬虫,还是你的 AI 数据“清洗机”!

扩展推荐

同类工具横向对比:

- Firecrawl:云服务版,简单但收费;Crawl4AI 免费自控更胜一筹

- ScrapeGraphAI:自然语言驱动,适合快速原型;但不如 Crawl4AI 稳定高效

- Scrapy:老牌框架,适合超大规模;但没内置 AI 优化,需要自己折腾 Markdown

小技巧提高效率:

- 用 deep crawl 模式批量抓站点:crwl https://example.com --deep-crawl bfs --max-pages 20

- 结合本地 LLM(如 Ollama)做零成本结构化提取

- 开启缓存避免重复爬:CacheMode.ENABLED

- 复杂页面加 JS 钩子:自定义点击“加载更多”按钮

更多进阶玩儿法,戳官网文档:https://docs.crawl4ai.com

总结语

Crawl4AI 是 2025 年 AI 开发者必备神器,越早用上越早领先——错过它太可惜了!赶紧星标 GitHub、收藏本文,转发给你的 AI 小伙伴,一起玩转网页数据吧!🚀

评论

发表评论

|

|

|